这是我们著名的使用 OpenAI 的“5 行代码”入门示例。

1. 下载数据

这个例子使用了保罗·格雷厄姆(Paul Graham)的文章“我做了什么”的文本。这个例子和许多其他例子可以在我们的 repo examples 文件夹中找到。

获取它的最简单方法是通过此链接下载它并将其保存在 data 目录下,文件名为:paul_graham_essay.txt

2. 设置 OpenAI API 密钥

LlamaIndex gpt-3.5-turbo 默认使用 OpenAI 的。通过将 API 密钥设置为环境变量,确保 API 密钥可用于代码。在 MacOS 和 Linux 中,以下命令:

|

1 |

export OPENAI_API_KEY=XXXXX |

在 Windows 上它是

|

1 |

set OPENAI_API_KEY=XXXXX |

3. 加载数据并构建索引

需要安装一些库

|

1 |

pip install llama-index-core |

如果运行下面的代码出问题,可能还需要安装和更新

|

1 |

pip install --upgrade pydantic langchain |

在创建 data 该文件夹的同一文件夹中,使用以下内容创建名为 starter.py 的文件

|

1 2 3 4 |

from llama_index.core import VectorStoreIndex, SimpleDirectoryReader documents = SimpleDirectoryReader("data").load_data() index = VectorStoreIndex.from_documents(documents) |

这将在 data 文件夹中的文档上构建索引(在本例中,该文件夹仅包含论文文本,但可能包含许多文档)。

目录结构应如下所示:

|

1 2 3 |

├── starter.py └── data └── paul_graham_essay.txt |

4. 查询数据

将以下行添加到 starter.py

|

1 2 3 |

query_engine = index.as_query_engine() response = query_engine.query("What did the author do growing up?") print(response) |

这将创建一个引擎,用于对索引进行问答,并提出一个简单的问题。您应返回类似于以下内容的响应: The author wrote short stories and tried to program on an IBM 1401.

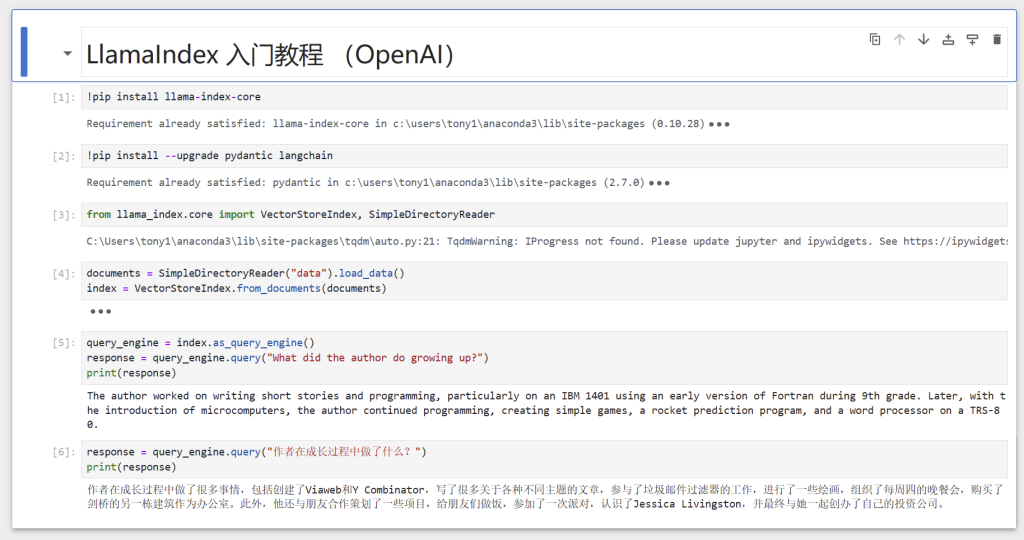

下面是jupyter notebook 运行的截图

5. 使用日志记录查看查询和事件

想看看引擎盖下发生了什么吗?让我们添加一些日志记录。将以下行添加到顶部: starter.py

|

1 2 3 4 5 |

import logging import sys logging.basicConfig(stream=sys.stdout, level=logging.DEBUG) logging.getLogger().addHandler(logging.StreamHandler(stream=sys.stdout)) |

下面是 DEBUG 下的输出情况

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 |