[ Ai2 最新发布 Tülu 3,基于 Llama 3.1 模型,首次完全开源了顶级语言模型的后训练全套方案(包括数据、方法、代码和评估体系),让任何开发者都能训练出接近 GPT、Claude、Gemini 水平的模型,打破大型科技公司在高性能 AI 模型上的垄断优势 ]

[ 后训练的重要性 ]

- 预训练模型并不能直接使用,需要经过后训练阶段

- 后训练包括指令微调和人类反馈学习

- 这个阶段对于模型的安全性和实用性至关重要

[ 当前后训练的挑战 ]

- 在增强特定能力(如编程)时可能会削弱其他能力(如写诗)

- 需要精确平衡数据混合和超参数

- 目前主流公司(OpenAI、Anthropic等)的后训练方法都不透明

[ Tülu 3 的创新之处 ]

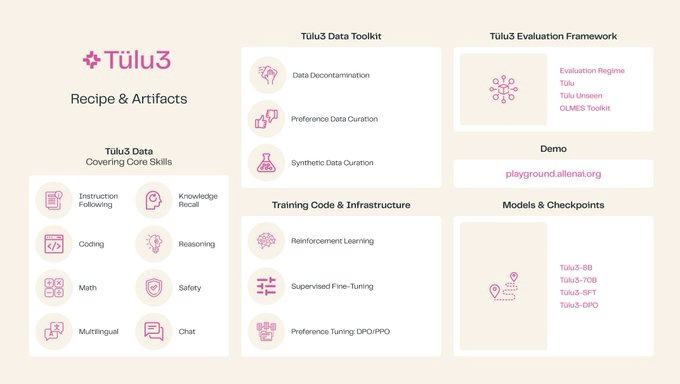

首次完全开源后训练框架,包括:

- 数据集

- 训练方法

- 代码

- 基础设施

- 评估框架

引入了新的训练方法:

- 直接在可验证问题上进行强化学习

- 使用模型自身生成来创建高质量偏好数据

[ 实用价值 ]

- 让任何研究者或开发者都可以训练出接近 GPT、Claude、Gemini 质量的模型

- 支持混合搭配不同数据集来定制模型能力

- 计算资源需求相对较低

- 提供了完整的评估框架

模型技术报告、开源模型、数据库、代码都已完全开源 👇

Chat with Tülu 3 in the Ai2 Playground

https://playground.allenai.org

Read the paper

https://allenai.org/papers/tulu-3-report.pdf

Tülu 3 70B on Hugging Face

https://huggingface.co/allenai/Llama-3.1-Tulu-3-70B

Tülu 3 8B on Hugging Face

https://huggingface.co/allenai/Llama-3.1-Tulu-3-8B

Tülu 3 dataset on Hugging Face

https://huggingface.co/collections/allenai/tulu-3-datasets-673b8df14442393f7213f372

Tülu 3 on GitHub

https://github.com/allenai/open-instruct